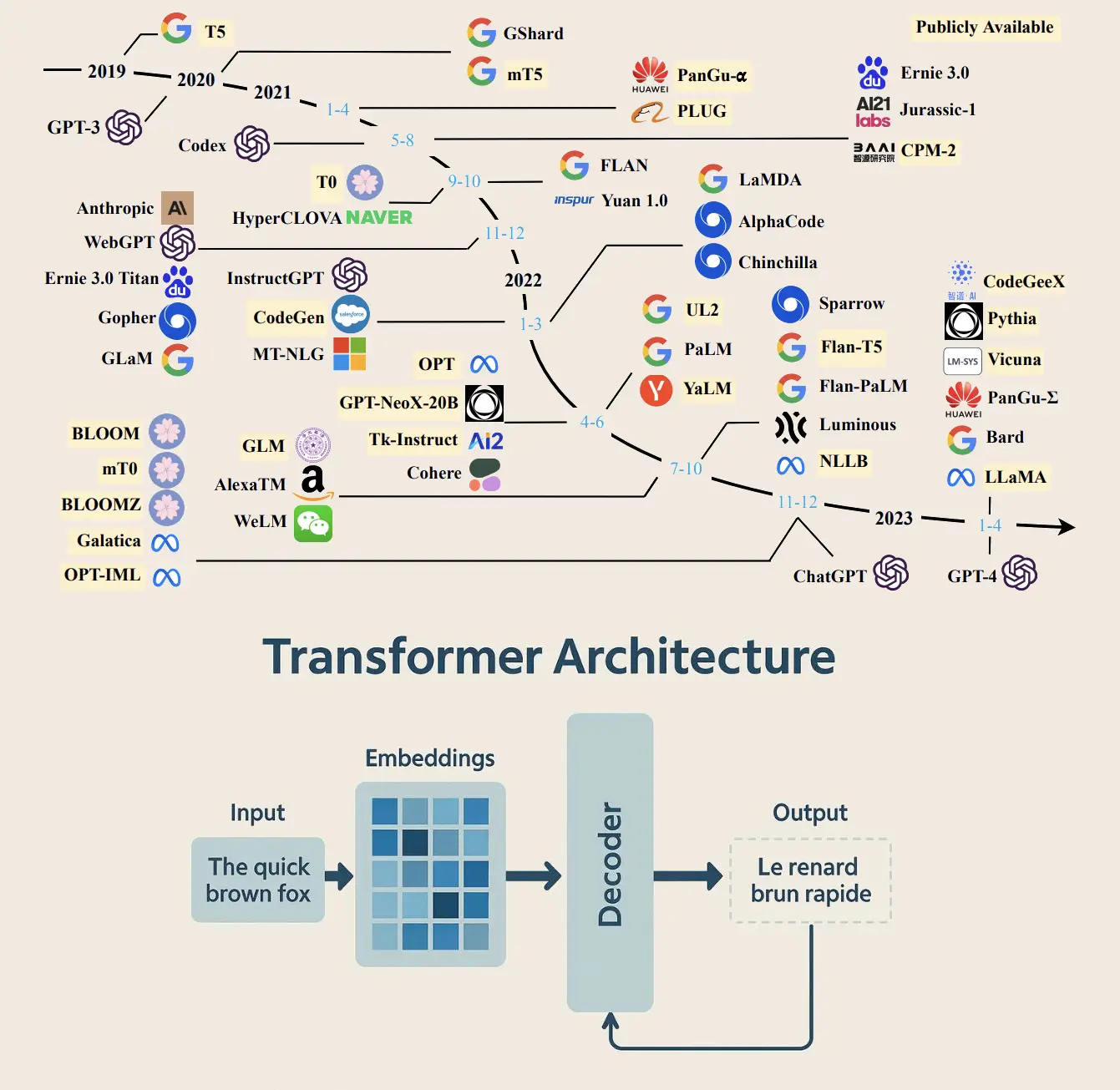

İlk zamanlarda dil modellemede RNN ve LSTM gibi ardışıl yapılar kullanılıyordu. Bu modeller sırayla veri işler, geçmişten gelen bilgiyi hatırlamaya çalışırlardı fakat uzun cümlelerde kafaları biraz karışırdı. Ayrıca, paralel işlemeye pek uygun değildiler. Derken sahneye Transformer mimarisi çıktı ve işler değişti. “Attention” mekanizması sayesinde model tüm kelimelere aynı anda odaklanabiliyor, bağlamı çok daha iyi kurabiliyordu. GPT serisiyle bu dönüşüm hız kazandı. GPT-2 yazmayı öğrendi, GPT-3 daha tutarlı oldu, GPT-4 ise çok yönlü düşünebilir hale geldi. Şimdi Gemini gibi modeller sadece metinle değil, görsel, ses gibi çoklu verilerle de çalışıyor. Artık sırayla düşünmek yerine, büyük resme odaklanan modeller çağındayız. Bu da yapay zeka alanında bambaşka bir dönemi başlatmış oldu diyebilirz.

Transformers Model Nedir ? Ne İşe Yarar ?

Transformer modeli, verileri sırayla değil aynı anda işler. Bu sayede hızlıdır.

Hangi kelimenin önemli olduğunu anlamak için dikkat (attention) mekanizması kullanır.

Uzun cümlelerdeki bağlamı daha iyi korur, unutma problemi yaşamaz.

Metin üretme, çeviri yapma, özet çıkarma gibi görevlerde kullanılır.

Görsel, ses gibi farklı veri türleriyle de çalışabilen sürümleri vardır.

GPT, BERT gibi gelişmiş yapay zekâ modelleri Transformer mimarisine dayanır.

Transformers Mimarisini Önemli Yapan Nedir ?

Transformer mimarisini önemli yapan şey, verilerdeki tüm kelimelere aynı anda bakabilmesi ve her kelimenin diğerleriyle olan ilişkisini dikkat (attention) mekanizmasıyla değerlendirmesidir. Bu sayede, uzun cümleleri unutmadan anlayabilir, anlam bütünlüğünü koruyarak çok daha doğru sonuçlar üretebilir. Ayrıca, paralel işlemeye uygun olduğu için eğitim süresi daha hızlıdır ve büyük veriyle çalışmaya elverişlidir. Bu özellikler, Transformer’ı dil çevirisinden sohbet botlarına, özetlemeden görsel yorumlamaya kadar birçok yapay zekâ uygulamasının temel taşı hâline getirmiştir.

Transformers Geliştirme Kullanılan Python Kütüphaneleri

TensorFlow: Google tarafından geliştirilmiş, geniş kapsamlı bir derin öğrenme kütüphanesidir. Transformers mimarisi burada kolayca kurulabilir.

PyTorch: Facebook tarafından geliştirilen, özellikle araştırma ve esneklik açısından çok tercih edilen bir kütüphanedir. Transformer tabanlı modellerin çoğu burada geliştirilir.

Hugging Face Transformers: PyTorch ve TensorFlow ile uyumlu, önceden eğitilmiş yüzlerce Transformer modelini kolayca kullanmayı sağlar.

Tokenizers: Hugging Face tarafından sağlanan, hızlı ve verimli metin ön işleme (tokenization) yapar.

Optuna veya Ray Tune: Transformer modelleri için hiperparametre optimizasyonu yapılırken kullanılır